Priyanjali Gupta est une jeune étudiante ingénieure de 20 ans. Elle a développé une intelligence artificielle capable de traduire la langue des signes.

Priyanjali Gupta est une jeune étudiante ingénieure de 20 ans. Elle a développé une intelligence artificielle capable de traduire la langue des signes.

La jeune fille a développé son modèle en utilisant API Tensorflow, un outil qui reconnait les objets. Elle l’a un peu bidouillé pour arriver à ses fins.

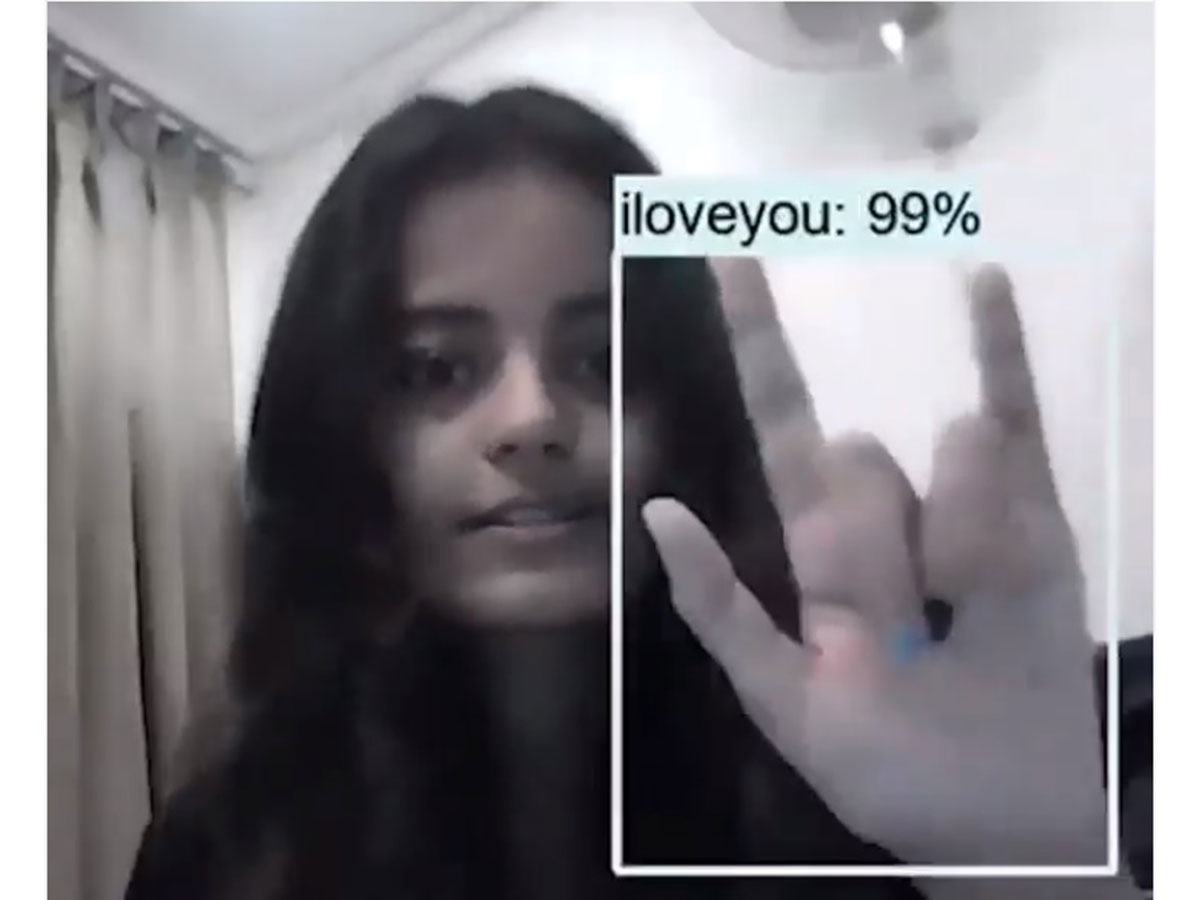

Son algorithme est capable de détecter et traduire, en temps réel, la langue des signes américaine (la LS n’est malheureusement pas universelle). Son logiciel utilise la webcam. Il reconnaît automatiquement le geste fait par la personne et le traduit à l’écrit. Celle-ci est accompagnée d’un pourcentage de fiabilité. (voir la vidéo qu’elle a posté sur son compte Linkedin).

Pour l’instant l’ingénieure est au début de ce développement. Son iA détecte quelques mots comme « S’il te plait », « oui » « non », « je t’aime ».

L’étudiante a déclaré : « Selon moi, les chercheurs et les développeurs font de leur mieux pour trouver une solution qui puisse être mise en œuvre. Mais la première étape consisterait à normaliser les langues des signes et les autres modes de communication avec les personnes handicapées pour s’efforcer de combler le fossé de la communication ». A suivre donc…